Nvidia vẫn là trung tâm của câu chuyện về phần cứng AI, nhưng hãng không còn hoạt động đơn độc nữa.

Tại các trung tâm dữ liệu, GPU của Nvidia hỗ trợ hầu hết các mô hình ngôn ngữ lớn hiện nay. Các nhà phân tích ước tính công ty vẫn kiểm soát khoảng 80 đến 90% thị trường máy gia tốc AI, với các chip H100 và H200 tạo thành xương sống của cơ sở hạ tầng đào tạo AI toàn cầu.

Đồng thời, các đối thủ cạnh tranh đang phát triển nhanh hơn, các khách hàng lớn đang tìm kiếm nhà cung cấp thứ hai, và các chip tùy chỉnh từ nền tảng đám mây đang bắt đầu chiếm lĩnh thị trường. Sự kết hợp này hiện đang định hình cả con đường tăng trưởng của Nvidia lẫn cơ cấu giao dịch trên toàn bộ mảng chip AI.

Bài bình luận này chỉ mang tính chất thông tin và không phải là lời khuyên đầu tư.

Cuộc đua chip AI năm 2025

Nền kinh tế AI đang thu hút sự quan tâm lớn, khơi thông các dòng vốn đầu tư khổng lồ vào lĩnh vực chip và trung tâm dữ liệu. Bloomberg Intelligence ước tính AI tạo sinh có thể tạo ra doanh thu khoảng 2 nghìn tỷ đô la vào năm 2032.

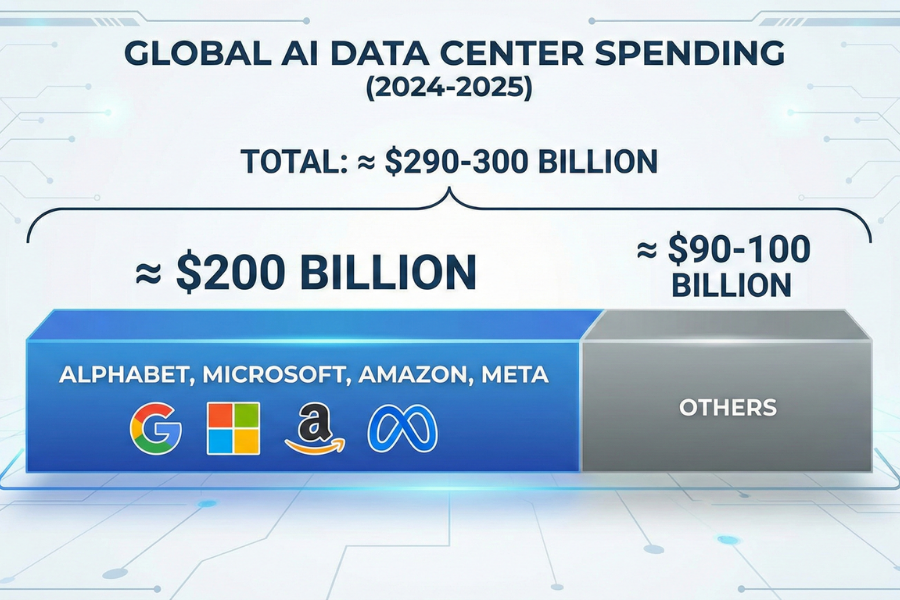

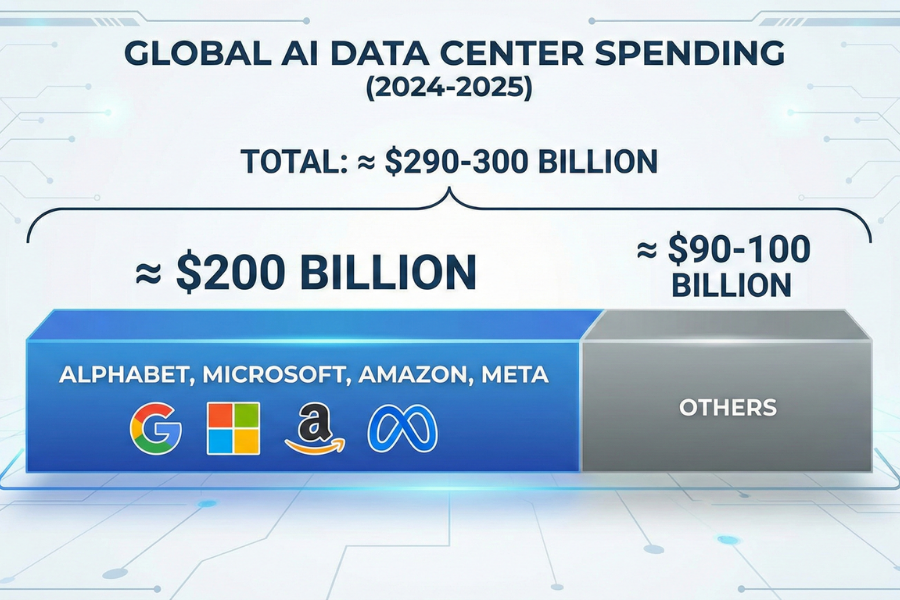

Chi tiêu cho cơ sở hạ tầng trung tâm dữ liệu toàn cầu gắn liền với AI sẽ đạt mức gần 290 đến 300 tỷ đô la vào năm 2024-2025, trong đó Alphabet, Microsoft, Amazon và Meta chiếm gần 200 tỷ đô la.

Về phía cung, AMD dự đoán thị trường chip AI rộng hơn, bao gồm bộ tăng tốc, CPU và mạng, có thể đạt giá trị khoảng 1 nghìn tỷ đô la vào năm 2030.

Dự báo đó giả định rằng vị thế gần như độc quyền hiện tại của Nvidia trong lĩnh vực tăng tốc AI sẽ dần mất đi khi các đối thủ tung ra phần cứng cạnh tranh hơn.

Đối với các nhà giao dịch, điều này quan trọng theo hai cách:

Nó tạo ra nguồn doanh thu tiềm năng rất lớn cho Nvidia và các công ty cùng ngành.

Điều này làm tăng nguy cơ biên lợi nhuận và thị phần hiện tại của Nvidia phải chịu áp lực từ các loại chip mới và giá cả.

Các đối thủ cạnh tranh chính của Nvidia trong lĩnh vực phần cứng AI

Dưới đây là danh sách những cái tên chính có công nghệ và hiệu suất cổ phiếu ảnh hưởng trực tiếp nhất đến cách các nhà đầu tư nghĩ về Nvidia.

1. AMD (AMD): Đối thủ GPU gần nhất

Advanced Micro Devices (AMD) là đối thủ cạnh tranh trực tiếp dễ thấy nhất của Nvidia trong lĩnh vực GPU trung tâm dữ liệu.

Dòng sản phẩm Instinct MI300 của công ty hiện đã được chuyển đến các nhà cung cấp đám mây lớn và ban quản lý đã hướng đến doanh thu GPU cho trung tâm dữ liệu AI đạt khoảng 4,5 tỷ đô la trong năm nay, với tầm nhìn dài hạn hướng tới thị trường chip AI trị giá 1 nghìn tỷ đô la.

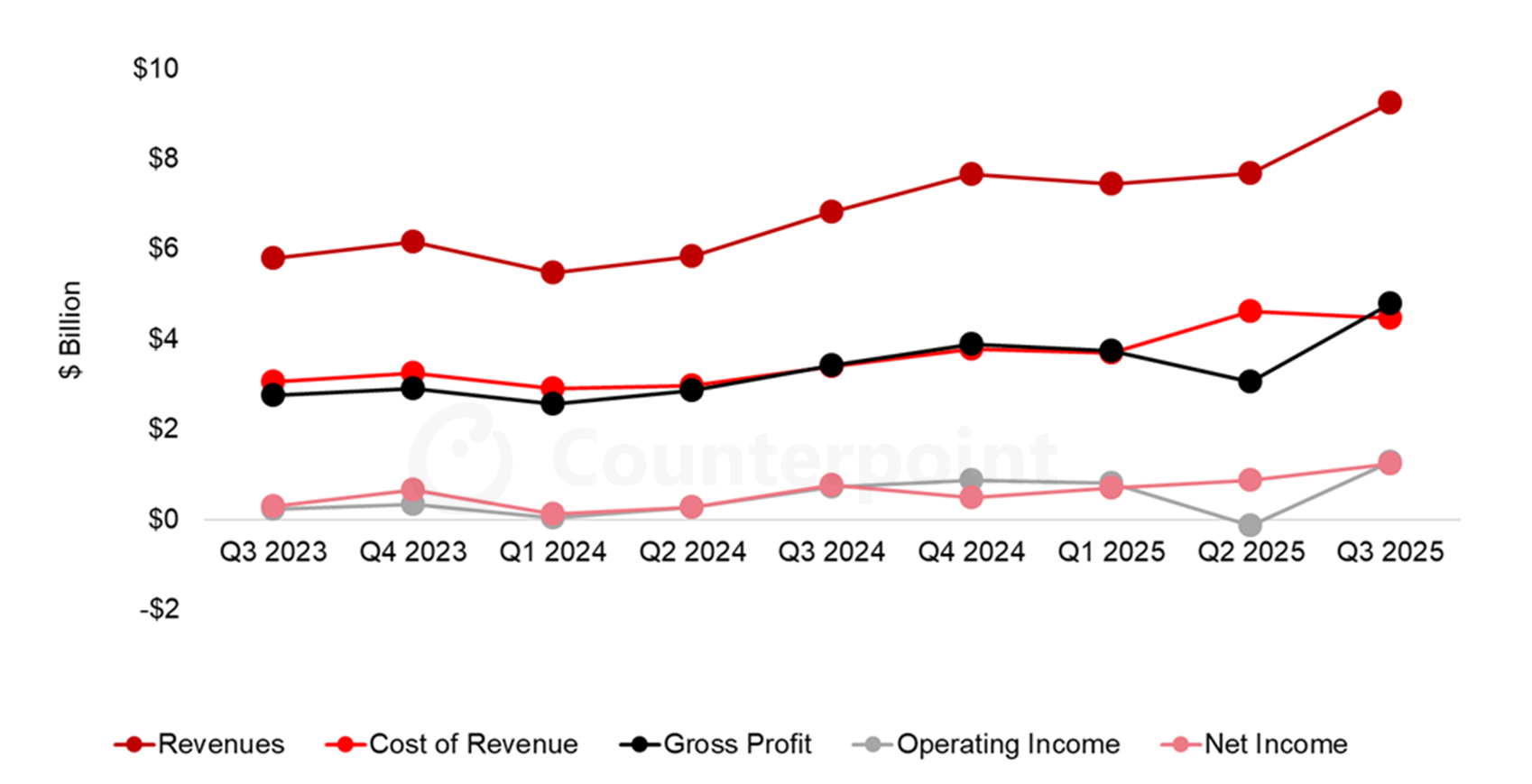

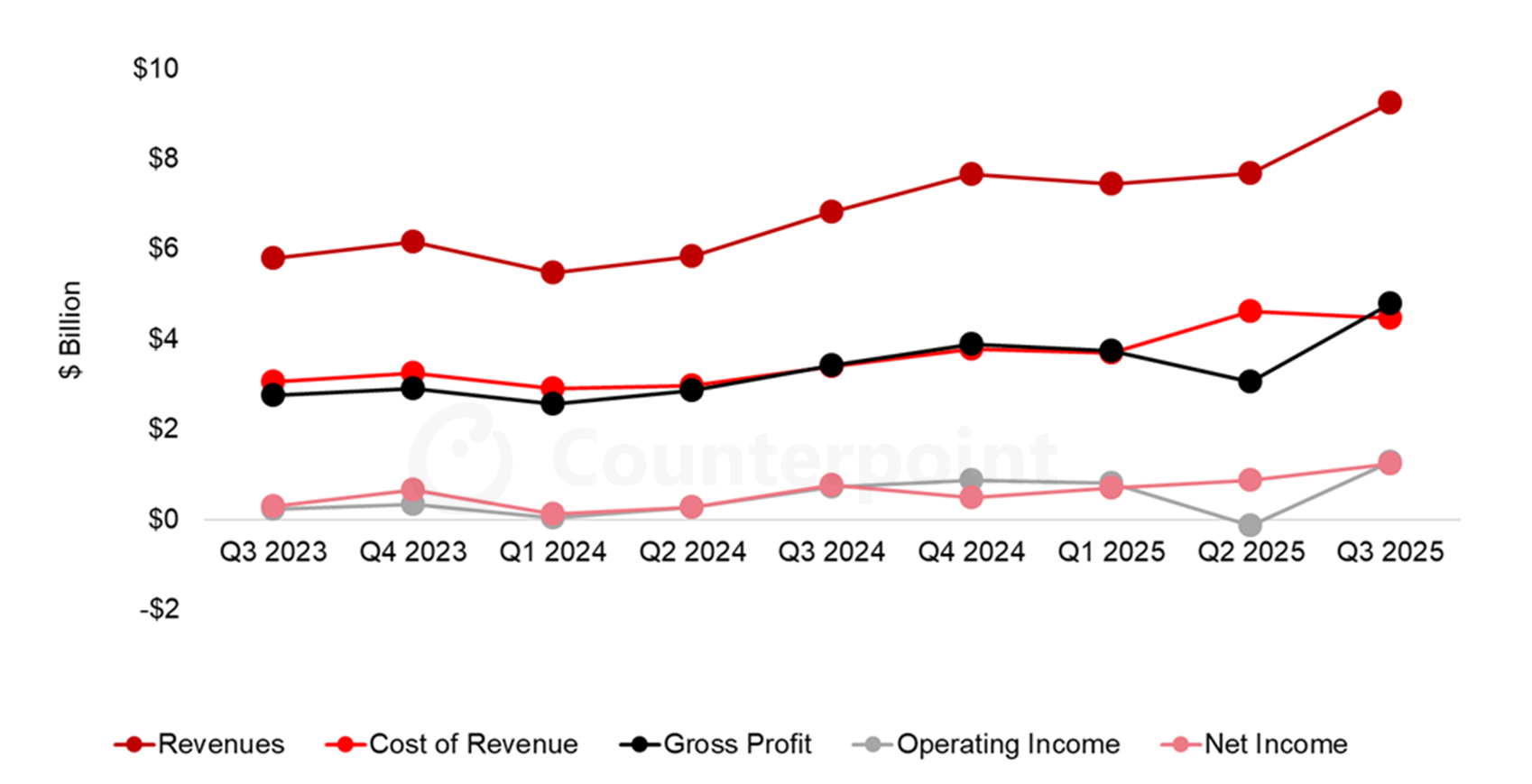

Doanh thu quý 3 năm 2025 đạt khoảng 9,2 tỷ đô la, tăng 36% so với cùng kỳ năm ngoái, với EPS vượt kỳ vọng và công ty kỳ vọng sẽ tiếp tục tăng trưởng trong quý 4 nhờ các sản phẩm AI.

Tác động đến Nvidia:

Các khách hàng lớn như Microsoft, Meta và OpenAI rất muốn tránh phụ thuộc vào một nhà cung cấp duy nhất. Ngay cả việc sử dụng một phần GPU của AMD cũng mang lại cho họ lợi thế về giá khi đàm phán với ông trùm chip AI Nvidia.

Khi các tiêu đề đưa tin về chiến thắng của AMD hoặc dự báo tích cực về AI, các nhà đầu tư thường luân chuyển giữa hai cổ phiếu này thay vì rót thêm tiền vào ngành. Điều này có thể hạn chế đà tăng trưởng ngắn hạn của Nvidia, đặc biệt là khi định giá công nghệ có vẻ đang bị kéo căng.

2. Intel (INTC): Bộ tăng tốc AI và GPU của Gaudi

Tập đoàn Intel (INTC) đang cố gắng quay trở lại cuộc đua điện toán hiệu năng cao với dòng sản phẩm tăng tốc AI Gaudi và GPU Arc Pro mới dành cho AI và khối lượng công việc của máy trạm.

Tại Computex 2025, công ty đã công bố khả năng cung cấp rộng rãi hơn Gaudi 3 ở định dạng rack-scale và PCIe, nhắm mục tiêu đến các nhà cung cấp đám mây và AI doanh nghiệp.

Mặc dù cơ sở doanh thu AI của Intel vẫn còn nhỏ so với Nvidia, nhưng mỗi lần triển khai Gaudi đáng tin cậy đều mang đến cho các nhà cung cấp dịch vụ siêu quy mô một lựa chọn thứ hai hoặc thứ ba cho việc đào tạo và suy luận. Theo thời gian, điều này sẽ làm giảm khả năng tính giá cao cho mỗi GPU của Nvidia.

3. Alphabet / Google (GOOGL): TPU là mối đe dọa trực tiếp

Công ty mẹ của Google là Alphabet hiện là một trong những đối thủ cạnh tranh lâu dài đáng gờm nhất của Nvidia, mặc dù hầu hết chip AI của công ty này đều được sử dụng nội bộ hoặc bán thông qua Google Cloud.

Bộ xử lý tensor (TPU) của Google là bộ tăng tốc AI tùy chỉnh chạy các mô hình và khối lượng công việc của khách hàng.

Tài liệu về đám mây cho thấy các phiên bản TPU v5e và v6e mới hơn có thể mang lại hiệu suất tốt hơn gấp nhiều lần trên mỗi đô la cho một số tác vụ suy luận nhất định so với các thiết lập GPU tương đương và một số nghiên cứu điển hình cho thấy chi phí suy luận thấp hơn từ 50 đến 65 phần trăm khi khối lượng công việc chuyển từ cụm GPU Nvidia sang TPU.

Sự thay đổi thực sự vào năm 2025 là thương mại:

Có báo cáo cho biết Meta đang đàm phán để chi hàng tỷ đô la cho TPU của Google từ năm 2027 và có thể thuê TPU thông qua Google Cloud ngay từ năm sau.

Phản ứng của thị trường rất mạnh mẽ. Sau những tin tức này, giá trị thị trường của Nvidia đã giảm hơn 100 tỷ đô la chỉ trong một ngày, trong khi cổ phiếu Alphabet lại tăng lên mức cao mới.

Ngay cả khi một hoặc hai công ty siêu quy mô chuyển 10 phần trăm chi phí đầu tư AI trong tương lai của họ từ Nvidia sang TPU, điều này có thể làm chậm tốc độ tăng trưởng trung tâm dữ liệu của Nvidia và nén giá trị định giá của công ty.

4. Broadcom (AVGO): ASIC AI tùy chỉnh và mạng

Broadcom không phải là nhà cung cấp GPU, nhưng hãng này đồng thiết kế bộ tăng tốc AI và chip mạng với các công ty siêu quy mô, bao gồm các thành phần được liên kết với nền tảng TPU của Google.

Vị thế là nhà cung cấp mạng tốc độ cao và silicon tùy chỉnh mang đến cho các khách hàng đám mây lớn một giải pháp thay thế: thay vì mua hệ thống Nvidia trọn gói, họ có thể thiết kế ASIC của riêng mình với Broadcom và dựa vào các thiết bị chuyển mạch và kết nối của Broadcom để mở rộng cụm.

Điều đó làm giảm cơ hội của Nvidia trong việc thu được từng đô la chi tiêu cho phần cứng AI, ngay cả khi GPU vẫn là cốt lõi của nhiều hệ thống.

5. Marvell Technology (MRVL): Chuyên gia kết nối AI

Marvell tập trung vào hệ thống mạng của các trung tâm dữ liệu AI: kết nối quang học, ASIC tùy chỉnh và silicon mạng kết nối hàng nghìn GPU hoặc XPU.

Tài liệu của công ty và các phân tích gần đây nêu bật tổng thị trường liên quan đến AI đang phát triển, khẳng định vị thế của Marvell trong nhóm cổ phiếu có tốc độ tăng trưởng cao với tổng giá trị khoảng 55 tỷ đô la cho silicon tùy chỉnh và các kết nối.

Đối với Nvidia, Marvell không phải là đối thủ trực tiếp, nhưng nó giúp các nhà cung cấp dịch vụ đám mây dễ dàng xây dựng các hệ thống được thiết kế riêng, nơi Nvidia chỉ là một phần tử trong số rất nhiều phần tử. Điều này có thể hạn chế khả năng của Nvidia trong việc tích hợp các thiết kế full-stack trên mạng, bộ chuyển mạch và bộ tăng tốc.

6. Qualcomm (QCOM): Chuyển đổi AI sang Edge

Nền tảng Snapdragon của Qualcomm, bao gồm chip PC thế hệ 8 Gen 5 và X-series mới nhất, tích hợp NPU mạnh mẽ cho AI trên thiết bị.

Khi ngày càng nhiều khối lượng công việc AI chạy trực tiếp trên điện thoại và PC, các tác vụ từ nhẹ đến trung bình có thể cần ít tác vụ hơn để xử lý trên GPU đám mây. Theo thời gian, điều này sẽ phân chia nhu cầu giữa các bộ tăng tốc trung tâm dữ liệu và điện toán biên.

Điều đó không loại bỏ nhu cầu sử dụng GPU Nvidia, nhưng có thể làm chậm tốc độ tăng trưởng của các yêu cầu suy luận đám mây, đặc biệt là đối với các mô hình nhỏ hơn hoặc nhạy cảm với độ trễ.

7. Arm Holdings (ARM): Kiến trúc đằng sau CPU AI và NPU

Arm không bán chip hoàn thiện với số lượng lớn. Thay vào đó, họ cấp phép các kiến trúc CPU và NPU được sử dụng bên trong nhiều bộ xử lý có khả năng AI.

Các nền tảng mới như hệ thống tính toán Lumex của Arm và Armv9.7-A tập trung vào thông lượng AI cao hơn, hoạt động ma trận và bảo mật tốt hơn, mở rộng trên các thiết bị, phương tiện và trung tâm dữ liệu.

Lõi AI được tối ưu hóa của Arm càng được sử dụng rộng rãi thì các OEM càng dễ dàng thiết kế chip AI của riêng mình thay vì hoàn toàn phụ thuộc vào hệ sinh thái của Nvidia.

8. TSMC (TSM): Nhà cung cấp quan trọng và lực lượng chiến lược thầm lặng

Taiwan Semiconductor Manufacturing không phải là đối thủ cạnh tranh trực tiếp, nhưng hãng này sản xuất hầu hết các GPU tiên tiến của Nvidia, cùng với chip cho AMD, Apple và các hãng khác.

Công ty này sản xuất hơn 90 phần trăm chip tiên tiến nhất thế giới và dự kiến doanh số bán hàng kỷ lục sẽ được thúc đẩy bởi nhu cầu về AI.

Những bình luận gần đây từ cả CEO của Nvidia và TSMC cho thấy Nvidia đang đẩy mạnh sản xuất wafer để đáp ứng các đơn đặt hàng AI. Cách TSMC phân bổ công suất tiên tiến giữa các đối thủ ảnh hưởng trực tiếp đến khả năng tăng trưởng doanh số của Nvidia.

9. Micron Technology (MU): Công ty dẫn đầu về bộ nhớ băng thông cao

Micron là trung tâm của phần cứng AI thông qua bộ nhớ băng thông cao (HBM), được xếp chồng trực tiếp bên cạnh các bộ tăng tốc AI. Các sản phẩm HBM3E của hãng cung cấp băng thông hơn 1,2 TB/giây cho mỗi khối và đã được thiết kế cho các nền tảng AMD Instinct hàng đầu.

SK Hynix và Micron cùng nhau thống trị thị trường HBM cấp AI và các phân tích gần đây chỉ ra mức tăng trưởng bộ nhớ AI hàng năm gần 30 phần trăm cho đến năm 2030, với dấu hiệu nguồn cung thắt chặt và giá tăng.

Chi phí bộ nhớ cao hơn có thể làm giảm biên lợi nhuận hệ thống của Nvidia hoặc thúc đẩy khách hàng khám phá các kiến trúc thay thế sử dụng bộ nhớ hiệu quả hơn.

Hình ảnh kỹ thuật: Nvidia và các đối tác chính

Xét về góc độ thị trường, Nvidia vẫn là cái tên tiêu biểu định hình xu hướng cho chip AI.

Thống kê giá và phạm vi gần đây, tính đến cuối tháng 11 năm 2025:

| Cổ phần |

Đóng cửa mới nhất (USD) |

Phạm vi 52 tuần (USD) |

Khoảng cách từ mức cao nhất trong 52 tuần |

Hiệu suất khoảng 1 năm |

| Nvidia (NVDA) |

177,82 |

86,62 – 212,19 |

~16% dưới mức cao |

~+31% |

| AMD (AMD) |

206,13 |

76,48 – 267,08 |

~23% dưới mức cao |

~+51% |

| TSMC (TSM) |

284,68 |

134,25 – 311,37 |

~9% dưới mức cao |

~+57% |

| Micron (MU) |

224,53 |

61,54 – 260,58 |

~14% dưới mức cao |

~+115% |

Một số điểm cần lưu ý về mặt kỹ thuật:

Nvidia vẫn đang duy trì xu hướng Uptrend rộng trong 1 năm, nhưng cổ phiếu đang củng cố dưới mức cao nhất trong 52 tuần. Điều này phản ánh cả mức tăng trưởng mạnh mẽ trước đó lẫn mối lo ngại ngày càng tăng về cạnh tranh và định giá.

AMD và Micron có hiệu suất giá 12 tháng mạnh hơn, mang đến cho các nhà giao dịch những lựa chọn thay thế thanh khoản khi tâm lý thị trường về Nvidia trở nên bất ổn.

Định giá kỳ hạn vẫn rất tốt trên toàn tập đoàn. Dữ liệu mới nhất cho thấy Nvidia và AMD đang giao dịch với hệ số P/E kỳ hạn – một chỉ số quan trọng trong các phương pháp định giá cổ phiếu – cao hơn TSMC và Micron, lần lượt ở mức dưới 20 và giữa 10.

Khi có tin tức về TPU của Google hoặc lựa chọn chip tiềm năng của Meta, thị trường thường phản ứng đầu tiên với Nvidia, sau đó điều chỉnh giá trên AMD, Broadcom, TSMC và Micron tùy thuộc vào bên nào trong ngành có vẻ dễ bị tổn thương hơn.

Cách các nhà giao dịch có thể định vị với EBC Financial Group

Đối với các nhà giao dịch, câu chuyện không phải là việc chọn ra một người chiến thắng duy nhất mà là việc hiểu được vốn sẽ luân chuyển đến đâu tiếp theo.

Với EBC Financial Group, khách hàng có thể:

Giao dịch Nvidia và các đối thủ cạnh tranh chính cùng với các chỉ số chính, cặp tiền tệ và hàng hóa.

Sử dụng các công cụ biểu đồ tiên tiến để theo dõi phạm vi, đột phá và sức mạnh tương đối trên các tên chip AI.

Quản lý rủi ro hiệu quả bằng cách thiết lập các mức Stop Loss và Take Profit hợp lý khi giao dịch cổ phiếu bán dẫn đầy biến động.

Kết hợp CFD cổ phiếu và chỉ số để phòng ngừa rủi ro danh mục đầu tư vào lĩnh vực công nghệ rộng lớn hơn.

Giao dịch các sản phẩm đòn bẩy tiềm ẩn mức độ rủi ro cao và có thể không phù hợp với tất cả nhà đầu tư. Bạn có thể mất nhiều hơn số tiền đầu tư ban đầu. Hãy cân nhắc mục tiêu của mình và tìm kiếm lời khuyên độc lập nếu cần.

Những câu hỏi thường gặp (FAQ)

1. Cổ phiếu nào là đối thủ cạnh tranh gần nhất của Nvidia trong lĩnh vực chip AI?

Trong lĩnh vực GPU trung tâm dữ liệu, AMD là đối thủ cạnh tranh trực tiếp nhất với dòng sản phẩm tăng tốc Instinct, hiện đang được phân phối rộng rãi đến các nhà cung cấp dịch vụ đám mây. Các bộ tăng tốc Gaudi của Intel và TPU của Google cũng rất quan trọng, nhưng hiện tại chúng chỉ nhắm đến một nhóm khối lượng công việc hẹp hơn.

2. TPU của Google ảnh hưởng như thế nào đến câu chuyện tăng trưởng của Nvidia?

TPU của Google cung cấp hiệu suất rẻ hơn cho một số tác vụ AI và những người mua lớn như Meta có thể áp dụng chúng từ năm 2027. Điều đó làm tăng nguy cơ chi tiêu cho AI trong tương lai sẽ chuyển một phần khỏi Nvidia.

3. Định giá chip AI có bị thổi phồng không?

Phân tích gần đây cho thấy thị phần công nghệ trên thị trường S&P 500 đã tăng nhanh hơn so với tỷ trọng lợi nhuận, và Nasdaq đang giao dịch cao hơn nhiều so với mức P/E dự phóng trung bình dài hạn. Nvidia, AMD và các công ty AI hàng đầu khác nằm trong số những cái tên đắt giá nhất, điều này làm tăng độ nhạy cảm với bất kỳ sự sụt giảm lợi nhuận hoặc dấu hiệu cạnh tranh nào.

4. Cổ phiếu bộ nhớ và đúc có cạnh tranh với Nvidia không?

Họ là đối tác nhưng vẫn cạnh tranh nhau về doanh thu phần cứng AI. TSMC kiểm soát năng lực sản xuất chip tiên tiến, trong khi Micron và SK Hynix thống trị nguồn cung HBM, do đó giá cả và sản lượng của họ định hình chi phí và tăng trưởng của Nvidia.

5. Tôi có thể giao dịch cổ phiếu chip AI này với EBC Financial Group không?

Có. EBC Financial Group cung cấp quyền truy cập vào Nvidia và nhiều đối thủ cạnh tranh chính của hãng thông qua các sản phẩm cổ phiếu hoặc CFD , cùng với các chỉ số chính và ngoại hối. Hãy luôn kiểm tra thông số kỹ thuật sản phẩm cho khu vực của bạn và lưu ý rằng giao dịch ký quỹ tiềm ẩn rủi ro đáng kể.

Cuối cùng

Nvidia vẫn là cổ phiếu chip AI chuẩn mực, chiếm thị phần lớn trong lĩnh vực tăng tốc AI và tăng trưởng thu nhập mạnh mẽ.

Đồng thời, danh sách các đối thủ cạnh tranh đáng tin cậy cũng ngày càng dài ra, từ GPU của AMD và bộ tăng tốc Gaudi của Intel đến TPU của Google, Broadcom và Marvell trong lĩnh vực silicon tùy chỉnh, và các nhà cung cấp như TSMC và Micron trong lĩnh vực sản xuất và bộ nhớ.

Đối với các nhà giao dịch, điều đó có nghĩa là câu chuyện về chip AI không còn là một giao dịch cổ phiếu đơn lẻ nữa. Đây là một lĩnh vực phải đối mặt với cạnh tranh, rủi ro định giá và dòng vốn rất lớn.

Theo dõi cách các tên này giao dịch với nhau có thể giúp xác định sự luân chuyển, phòng ngừa rủi ro và phát hiện ra các cơ hội mới khi chu kỳ phần cứng AI phát triển.

Nếu bạn đang cân nhắc giao dịch Nvidia hoặc các đối thủ cạnh tranh của công ty này, hãy sử dụng giới hạn rủi ro rõ ràng, theo dõi chặt chẽ luồng tin tức và làm việc với một nhà môi giới được quản lý như EBC Financial Group.

Tuyên bố miễn trừ trách nhiệm: Tài liệu này chỉ nhằm mục đích cung cấp thông tin chung và không nhằm mục đích (và không nên được coi là) tư vấn tài chính, đầu tư hoặc các hình thức tư vấn khác mà chúng ta nên tin cậy. Không có ý kiến nào trong tài liệu này cấu thành khuyến nghị của EBC hoặc tác giả rằng bất kỳ khoản đầu tư, chứng khoán, giao dịch hoặc chiến lược đầu tư cụ thể nào phù hợp với bất kỳ cá nhân cụ thể nào.