Mulai Trading

Tentang EBC

Diterbitkan pada: 2025-11-26

Nvidia masih menjadi pusat cerita perangkat keras AI, tetapi tidak lagi berjalan sendiri.

Di pusat data, GPU Nvidia mendukung sebagian besar model bahasa besar saat ini. Analis memperkirakan perusahaan masih menguasai sekitar 80 hingga 90 persen pasar akselerator AI, dengan chip H100 dan H200-nya menjadi tulang punggung infrastruktur pelatihan AI global.

Di saat yang sama, para competitors bergerak lebih cepat, pelanggan besar mencari pemasok kedua, dan chip khusus dari platform cloud mulai diminati. Kombinasi ini kini membentuk jalur pertumbuhan Nvidia dan pengaturan perdagangan di seluruh kompleks chip AI.

Komentar ini hanya untuk informasi dan bukan nasihat investasi.

Ekonomi AI menarik modal besar ke dalam chip dan pusat data. Bloomberg Intelligence memperkirakan AI generatif dapat menghasilkan pendapatan sekitar 2 triliun dolar pada tahun 2032.

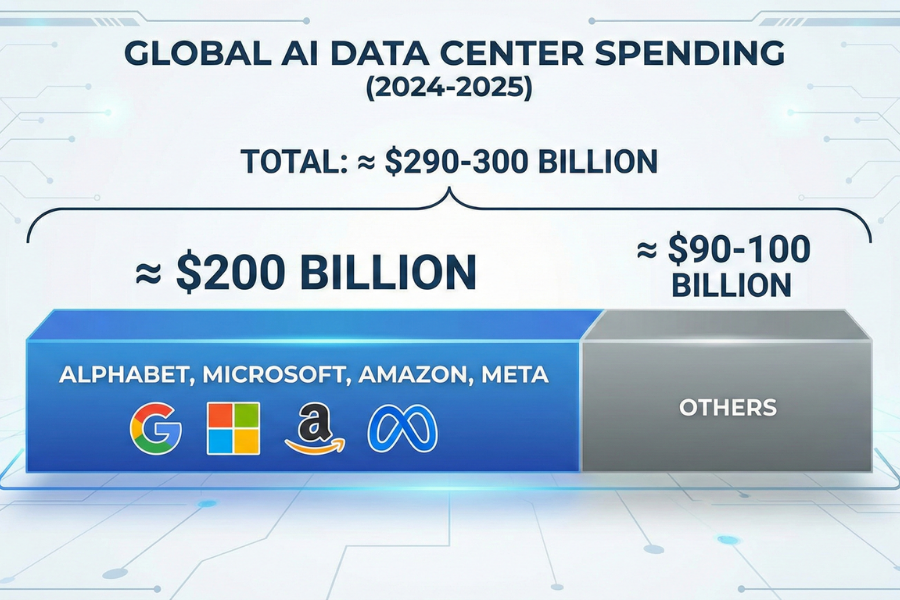

Pengeluaran infrastruktur pusat data global yang terkait dengan AI melacak mendekati 290 hingga 300 miliar dolar pada tahun 2024-2025, dengan Alphabet, Microsoft, Amazon, dan Meta bertanggung jawab atas hampir 200 miliar dolar di antaranya.

Di sisi pasokan, AMD memproyeksikan pasar chip AI yang lebih luas, termasuk akselerator, CPU, dan jaringan, dapat mencapai sekitar 1 triliun dolar pada tahun 2030.

Prakiraan itu mengasumsikan bahwa monopoli Nvidia saat ini dalam akselerator AI akan berangsur-angsur berkurang karena para competitors mengirimkan perangkat keras yang lebih kompetitif.

Bagi para pedagang, hal ini penting dalam dua hal:

Ini memberikan potensi pendapatan yang sangat besar bagi Nvidia dan para competitorsnya.

Hal ini meningkatkan risiko bahwa margin dan pangsa pasar Nvidia saat ini menghadapi tekanan dari chip dan harga baru.

Di bawah ini adalah nama-nama kunci yang tercantum yang teknologinya dan kinerja sahamnya paling langsung memengaruhi cara investor berpikir tentang Nvidia.

Advanced Micro Devices (AMD) adalah competitor langsung Nvidia yang paling menonjol dalam GPU pusat data.

Seri Instinct MI300 sudah dikirimkan ke penyedia cloud utama, dan manajemen telah mengarahkan pendapatan GPU pusat data AI sekitar 4,5 miliar dolar tahun ini, dengan pandangan jangka panjang pasar chip AI senilai 1 triliun dolar.

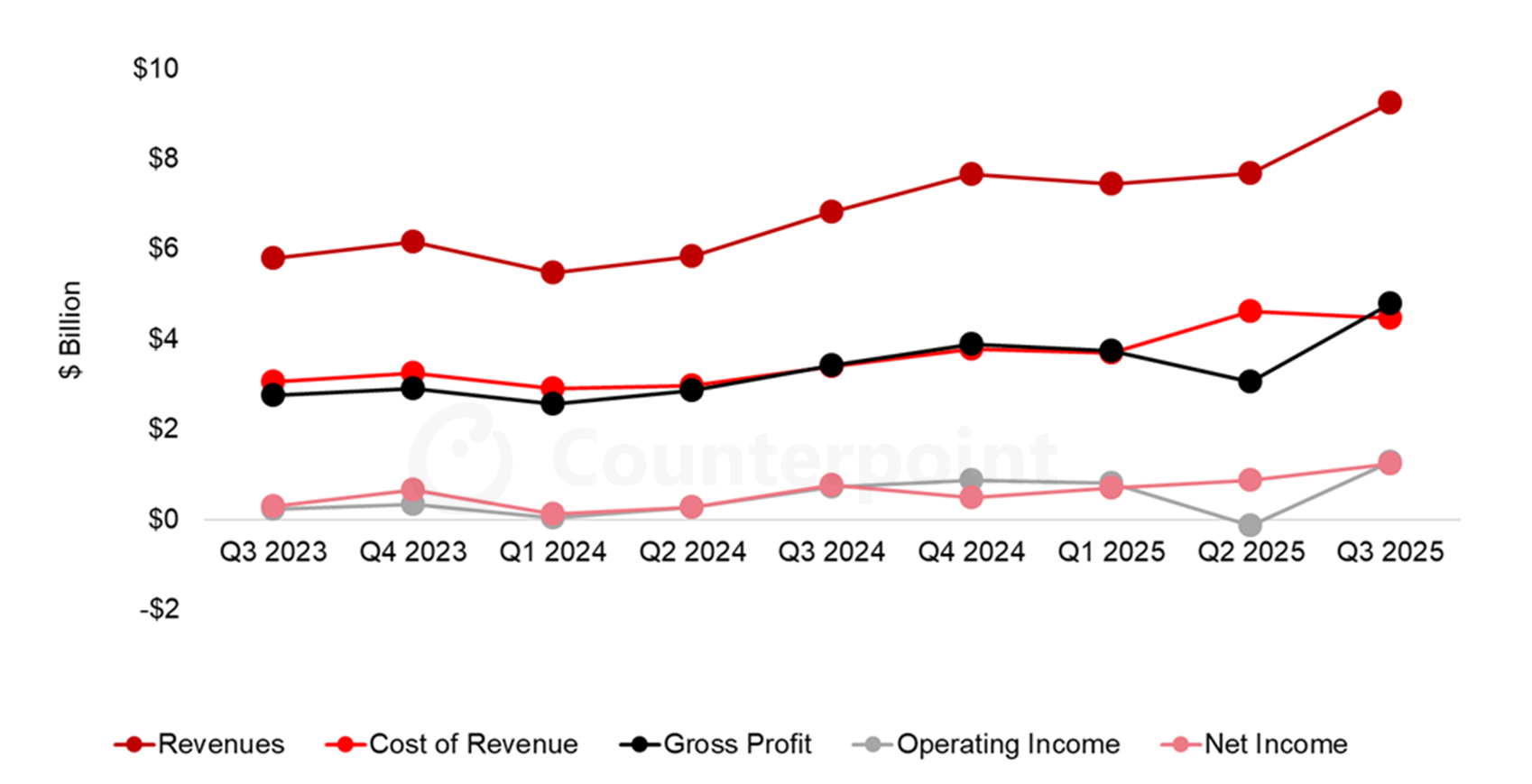

Pendapatan Q3 2025 mencapai sekitar 9,2 miliar dolar, naik 36 persen tahun ke tahun, dengan EPS di atas ekspektasi, dan perusahaan mengharapkan pertumbuhan lebih lanjut di Q4 yang didorong oleh produk AI.

Pelanggan besar seperti Microsoft, Meta, dan OpenAI ingin menghindari ketergantungan pada satu pemasok saja. Bahkan adopsi sebagian GPU AMD memberi mereka daya tawar harga saat bernegosiasi dengan Nvidia.

Ketika berita utama menyoroti kemenangan AMD atau arahan AI yang kuat, investor sering kali beralih di antara kedua saham tersebut alih-alih menambah dana baru ke sektor tersebut. Hal ini dapat membatasi potensi keuntungan jangka pendek Nvidia, terutama ketika valuasi teknologi terlihat terlalu tinggi.

Intel mencoba memasuki kembali perlombaan komputasi berkinerja tinggi dengan jajaran akselerator AI Gaudi dan GPU Arc Pro baru untuk beban kerja AI dan stasiun kerja.

Di Computex 2025, perusahaan mengumumkan ketersediaan Gaudi 3 yang lebih luas dalam format skala rak dan PCIe, yang menargetkan penyedia cloud dan AI perusahaan.

Meskipun basis pendapatan AI Intel masih kecil dibandingkan dengan Nvidia, setiap penerapan Gaudi yang kredibel memberikan hyperscaler opsi kedua atau ketiga untuk pelatihan dan inferensi. Seiring waktu, hal ini mengikis kemampuan Nvidia untuk menetapkan harga premium per GPU.

Alphabet sekarang menjadi salah satu competitor jangka panjang Nvidia yang paling serius, meskipun sebagian besar chip AI-nya digunakan secara internal atau dijual melalui Google Cloud.

Unit pemrosesan tensor (TPU) Google adalah akselerator AI khusus yang menjalankan model dan beban kerja pelanggannya sendiri.

Dokumentasi cloud menunjukkan instans TPU v5e dan v6e yang lebih baru dapat menawarkan kinerja beberapa kali lebih baik per dolar untuk tugas inferensi tertentu daripada pengaturan GPU yang sebanding, dan beberapa studi kasus menunjukkan biaya inferensi 50 hingga 65 persen lebih rendah saat beban kerja berpindah dari kluster GPU Nvidia ke TPU.

Laporan mengatakan Meta sedang dalam pembicaraan untuk menghabiskan miliaran dolar pada TPU Google mulai tahun 2027, dan mungkin menyewa TPU melalui Google Cloud paling cepat tahun depan.

Reaksi pasar sangat tajam. Setelah berita utama ini, nilai pasar Nvidia anjlok lebih dari 100 miliar dolar dalam sehari, sementara saham Alphabet naik ke level tertinggi baru.

Jika satu atau dua hyperscaler mengalihkan 10 persen belanja modal AI masa depan mereka dari Nvidia ke TPU, hal itu dapat memperlambat pertumbuhan pusat data Nvidia dan menekan kelipatan valuasinya.

Broadcom bukan vendor GPU, tetapi ikut merancang akselerator AI dan chip jaringan dengan hyperscaler, termasuk komponen yang terhubung ke platform TPU Google.

Posisinya sebagai pemasok silikon khusus dan jaringan berkecepatan tinggi memberi pelanggan cloud besar jalur alternatif: alih-alih membeli sistem Nvidia secara menyeluruh, mereka dapat mendesain ASIC mereka sendiri dengan Broadcom dan mengandalkan sakelar dan interkoneksinya untuk meningkatkan skala kluster.

Hal itu mengurangi peluang Nvidia untuk mendapatkan setiap dolar dari pengeluaran perangkat keras AI, bahkan jika GPU tetap menjadi inti dari banyak sistem.

Marvell berfokus pada perpipaan pusat data AI: interkoneksi optik, ASIC khusus, dan silikon jaringan yang menghubungkan ribuan GPU atau XPU.

Materi perusahaan dan analisis terkini menyoroti pertumbuhan total pasar terkait AI yang mencapai sekitar 55 miliar dolar untuk silikon dan interkoneksi khusus, dan mencatat bahwa bisnis ASIC Marvell meningkat sekitar dua kali lipat seiring meningkatnya skalabilitas AI.

Bagi Nvidia, Marvell bukanlah competitor langsung, tetapi Marvell memudahkan penyedia cloud untuk membangun sistem yang dirancang khusus, sementara Nvidia hanyalah salah satu dari sekian banyak elemen. Hal ini dapat membatasi kemampuan Nvidia untuk menerapkan desain tumpukan penuh di seluruh jaringan, switch, dan akselerator.

Platform Snapdragon Qualcomm, termasuk chip PC Gen 5 dan seri X terbaru, mengintegrasikan NPU yang kuat untuk AI pada perangkat.

Seiring meningkatnya beban kerja AI yang berjalan langsung di ponsel dan PC, semakin sedikit tugas ringan hingga sedang yang perlu ditangani GPU cloud. Seiring waktu, hal ini membagi permintaan antara akselerator pusat data dan komputasi edge.

Hal itu tidak menghilangkan kebutuhan akan GPU Nvidia, tetapi dapat memperlambat laju pertumbuhan persyaratan inferensi cloud, terutama untuk model yang lebih kecil atau sensitif terhadap latensi.

Arm tidak menjual chip jadi dalam skala besar. Sebaliknya, Arm melisensikan arsitektur CPU dan NPU yang digunakan dalam banyak prosesor berkemampuan AI.

Platform baru seperti subsistem komputasi Lumex Arm dan Armv9.7-A berfokus pada throughput AI yang lebih tinggi, operasi matriks dan keamanan yang lebih baik, yang mencakup perangkat, kendaraan, dan pusat data.

Semakin luas penyebaran inti Arm yang dioptimalkan untuk AI, semakin mudah bagi OEM untuk mendesain silikon AI mereka sendiri daripada bergantung sepenuhnya pada ekosistem Nvidia.

Taiwan Semiconductor Manufacturing bukanlah competitor langsung, tetapi memproduksi sebagian besar GPU canggih Nvidia, bersama dengan chip untuk AMD, Apple, dan lainnya.

Perusahaan ini memproduksi lebih dari 90 persen chip tercanggih di dunia dan mengharapkan rekor penjualan didorong oleh permintaan AI.

Komentar terbaru dari CEO Nvidia dan TSMC menunjukkan bahwa Nvidia sedang mendorong lebih banyak wafer untuk memenuhi pesanan AI. Cara TSMC mengalokasikan kapasitas mutakhir di antara para competitors secara langsung memengaruhi kemampuan Nvidia untuk meningkatkan pengiriman unit.

Micron menjadi pusat perangkat keras AI melalui memori bandwidth tinggi (HBM), yang ditempatkan tepat di samping akselerator AI. Produk HBM3E-nya menghadirkan bandwidth lebih dari 1,2 TB/dtk per kubus dan telah dirancang ke dalam platform AMD Instinct terkemuka.

SK Hynix dan Micron bersama-sama mendominasi HBM bermutu AI, dan analisis terkini menunjukkan pertumbuhan memori AI tahunan mendekati 30 persen hingga tahun 2030, dengan tanda-tanda semakin ketatnya pasokan dan naiknya harga.

Biaya memori yang lebih tinggi dapat menekan margin sistem Nvidia atau mendorong pelanggan untuk mengeksplorasi arsitektur alternatif yang menggunakan memori secara lebih efisien.

Dari perspektif pasar, Nvidia masih menjadi nama referensi yang menentukan corak chip AI.

Statistik harga dan jangkauan terkini, per akhir November 2025:

| Saham | Penutupan Terakhir (USD) | Rentang 52 Minggu (USD) | Jarak dari Tertinggi 52 Minggu | Kinerja Sekitar 1 Tahun |

|---|---|---|---|---|

| Nvidia (NVDA) | 177.82 | 86,62 – 212,19 | ~16% di bawah tinggi | ~+31% |

| AMD (AMD) | 206.13 | 76,48 – 267,08 | ~23% di bawah tinggi | ~+51% |

| TSMC (TSM) | 284,68 | 134,25 – 311,37 | ~9% di bawah tinggi | ~+57% |

| Mikron (MU) | 224.53 | 61,54 – 260,58 | ~14% di bawah tinggi | ~+115% |

Nvidia masih berada dalam tren naik yang luas dalam proyeksi 1 tahun, tetapi sahamnya berkonsolidasi di bawah level tertinggi 52 minggu. Hal ini mencerminkan keuntungan besar sebelumnya dan meningkatnya kekhawatiran tentang persaingan dan valuasi.

AMD dan Micron memiliki kinerja harga 12 bulan yang lebih kuat, yang memberi pedagang alternatif likuid ketika sentimen memburuk terhadap Nvidia.

Valuasi forward tetap tinggi di seluruh grup. Data terbaru menunjukkan Nvidia dan AMD diperdagangkan dengan rasio P/E forward yang lebih tinggi daripada TSMC dan Micron, yang masing-masing mendekati kisaran 20-an rendah dan 10-an pertengahan.

Saat berita mengenai TPU milik Google atau pilihan chip potensial Meta mencuat, pasar sering kali bereaksi terlebih dahulu terhadap Nvidia, kemudian mengatur ulang harga untuk AMD, Broadcom, TSMC, dan Micron, tergantung pada sisi perdagangan mana yang terlihat lebih terbuka.

Bagi para pedagang, ceritanya bukan tentang memilih satu pemenang, tetapi lebih kepada memahami ke mana modal akan berputar selanjutnya.

Dengan EBC Financial Group, klien dapat:

Perdagangkan Nvidia dan competitors utamanya bersama indeks utama, pasangan mata uang asing, dan komoditas.

Gunakan alat grafik canggih untuk melacak rentang, terobosan, dan kekuatan relatif di seluruh nama chip AI.

Kelola risiko dengan perintah stop loss dan take profit saat memperdagangkan saham semikonduktor yang fluktuatif.

Gabungkan CFD saham dan indeks untuk melindungi eksposur portofolio ke sektor teknologi yang lebih luas.

Perdagangan produk dengan leverage melibatkan risiko tinggi dan mungkin tidak cocok untuk semua investor. Anda bisa kehilangan lebih dari investasi awal Anda. Pertimbangkan tujuan Anda dan carilah nasihat independen jika diperlukan.

Di GPU pusat data, AMD merupakan competitors terdekat yang sepadan melalui lini akselerator Instinct-nya, yang sudah dikirimkan dalam skala besar ke penyedia cloud. Akselerator Gaudi dari Intel dan TPU dari Google juga penting, tetapi saat ini keduanya menargetkan beban kerja yang lebih sempit.

TPU Google menawarkan kinerja yang lebih murah untuk beberapa tugas AI, dan pembeli besar seperti Meta mungkin akan mengadopsinya mulai tahun 2027. Hal ini meningkatkan risiko pergeseran sebagian pengeluaran AI di masa mendatang dari Nvidia.

Analisis terbaru menunjukkan pangsa pasar teknologi dalam kapitalisasi pasar S&P 500 telah meningkat lebih cepat daripada pangsa pendapatannya, dan Nasdaq diperdagangkan jauh di atas rata-rata P/E forward jangka panjangnya. Nvidia, AMD, dan perusahaan-perusahaan AI terkemuka lainnya termasuk di antara nama-nama termahal, yang meningkatkan sensitivitas terhadap kekecewaan pendapatan atau tanda-tanda persaingan.

Mereka memang mitra, tetapi tetap bersaing untuk mendapatkan dana perangkat keras AI. TSMC mengendalikan kapasitas chip canggih, sementara Micron dan SK Hynix mendominasi pasokan HBM, sehingga harga dan output mereka membentuk biaya dan pertumbuhan Nvidia.

Ya. EBC Financial Group menawarkan akses ke Nvidia dan banyak competitors utamanya melalui produk saham atau CFD , serta indeks utama dan valuta asing. Selalu periksa spesifikasi produk untuk wilayah Anda dan ingat bahwa perdagangan margin memiliki risiko yang signifikan.

Nvidia tetap menjadi saham chip AI yang menjadi acuan, dengan pangsa dominan akselerator AI dan pertumbuhan laba yang kuat.

Pada saat yang sama, daftar competitors yang kredibel makin bertambah, dari GPU AMD dan akselerator Gaudi Intel hingga TPU Google, Broadcom dan Marvell dalam silikon khusus, serta pemasok seperti TSMC dan Micron dalam manufaktur dan memori.

Bagi para pedagang, ini berarti kisah chip AI bukan lagi sekadar perdagangan saham tunggal. Sektor ini rentan terhadap persaingan, risiko valuasi, dan arus modal yang sangat besar.

Melacak bagaimana nama-nama ini diperdagangkan satu sama lain dapat membantu mengidentifikasi rotasi, risiko lindung nilai, dan menemukan peluang baru seiring berkembangnya siklus perangkat keras AI.

Jika Anda mempertimbangkan untuk memperdagangkan Nvidia atau competitorsnya, gunakan batasan risiko yang jelas, pantau arus berita secara ketat dan bekerjalah dengan pialang teregulasi seperti EBC Financial Group.

Penafian: Materi ini hanya untuk tujuan informasi umum dan tidak dimaksudkan (dan tidak boleh dianggap sebagai) nasihat keuangan, investasi, atau nasihat lain yang dapat diandalkan. Pendapat yang diberikan dalam materi ini tidak merupakan rekomendasi dari EBC atau penulis bahwa investasi, sekuritas, transaksi, atau strategi investasi tertentu cocok untuk orang tertentu.